Die Erforschung von Interaktionsparadigmen und Untersuchung von Interfaces standen, neben anderen Schwerpunkten, im Zentrum der Anfangsjahre von ART+COM. Unser Interesse wandte sich damals schnell von universellen zu inhaltsspezifischen Interfaces. Früh entwickelten wir semantische Interfaces, deren Benutzung intuitiv, quasi selbsterklärend, ist.

Zweckentfremdete Technologie, inhaltsspezifische und semantische Interfaces

Zu Beginn der 1990er Jahre hatte ART+COM über verschiedenste Kanäle Zugang zu neuesten Technologien, noch bevor diese einen praktischen Einsatz gefunden hatten. Als erste europäische Gestalter und Entwickler bekamen wir 1991 von VPL Research, Inc., einer Firma, die Jaron Lanier 1985 mitgegründet hatte, einen Datenhandschuh und eine Datenbrille zur Verfügung gestellt. Bei den Experimenten mit diesen von der Presse gehypten VR-Interfaces stellten wir fest, dass das von der Außenwelt isolierte Interagieren unter der Datenbrille nicht nutzerfreundlich war. Der fehlende realräumliche Bezug stellte eine zu große Beschränkung dar.

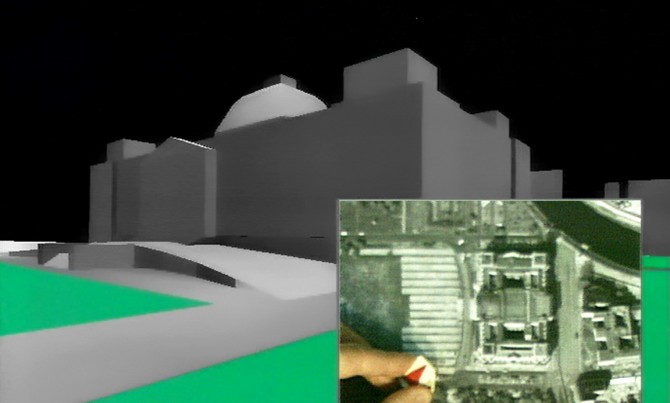

Wir ließen daher bei den Tests die Datenbrille weg und setzten bei der Navigation durch die 3D-Welten lediglich den Datenhandschuh ein. 1992 montiert wir den Polhemus Sensor, der ursprünglich auf der Datenbrille saß, ab und setzten ihn auf ein Luftbild von Berlin, um durch ein 3D-Modell der Stadt zu navigieren. Durch diese Zweckentfremdung und direkte Koppelung von Realraum und virtuellem Raum konnten sich Nutzer von Berlin – Cyber City (1989-91) intuitiv durch das virtuelle Berlin bewegen und beispielsweise Bebauungspläne betrachten und bewerten.

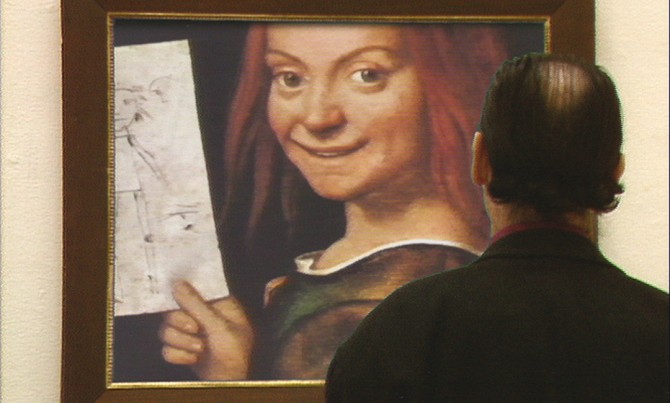

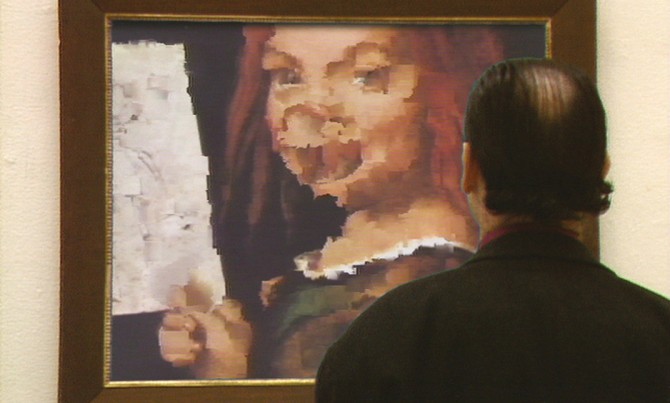

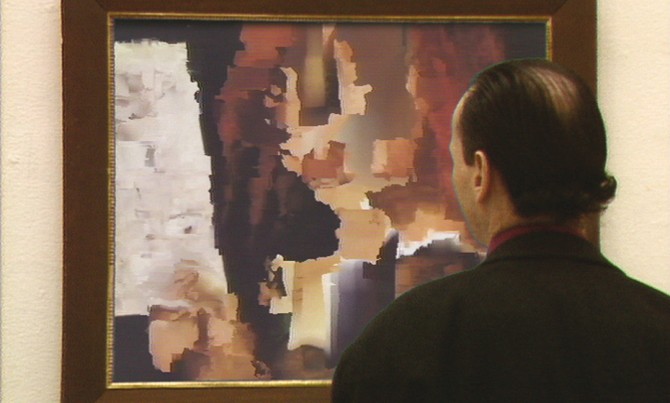

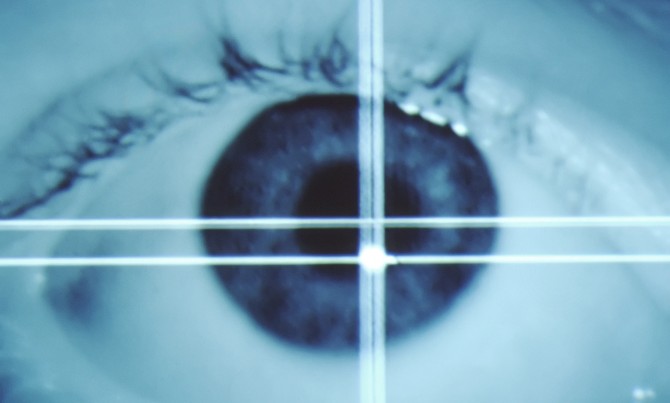

Das damals innovative Eye-Tracking, bestehend aus einer Kamera, einer Infrarotleuchte, einem Computer und einer Video-Tracking-Software, wurde seinerzeit nicht für die klassische User-Interaktion, sondern in erster Linie in der militärischen Forschung und als Analysetool in der Wahrnehmungsforschung eingesetzt. Wir zweckentfremdeten das System als Interface im Zerseher (1992), um das damals unterschätzte Konzept der medialen Interaktion in der Kunst provokativ zu propagieren. Beim Zerseher verändert der Rezeptionsprozess eines Bildes gleichzeitig das betrachtete Bild: Die Kamera nimmt das Auge des Betrachters auf, worauf die Software das Bild vom Auge in Echtzeit analysiert und das Zentrum der Iris und den Reflektionspunkt des Infrarotscheinwerfers im Auge erkennt. Aus diesen Daten wird der Punkt im digitalen Gemälde errechnet, auf den der Betrachter blickt. Diese Stelle verändert sich dann durch einen generativen Algorithmus in Echtzeit, sowie in der Folge alle Stellen, über die das Auge des Betrachters wandert.

Durch Experimente stellten wir fest, wie präzise und intuitiv der Mensch sich ausschließlich mit Augenbewegungen im Raum bewegen kann und nutzen es als Interface für die Navigation durch virtuelle Welten und in Projekten wie Berlin – Cyber City.

Gegenüber General Purpose Interfaces besitzen inhaltsspezifische Interfaces den Vorteil, das Spektrum der Interaktion zu begrenzen und Nutzer so zu leiten, dass sie sich auf die Inhalte konzentrieren können. Zudem können sie semantisch so gestaltet werden, dass ihre Funktion sofort lesbar ist.

Ein frühes Beispiel für ein semantisches Interface ist der Earthtracker, eines der drei Interfacekomponenten von Terravision (1994). Der Earthtracker war ein physisches Globusmodel zur Navigation auf einer virtuellen Erde und durch mehrere darüber geblendete Informationsebenen. Der Earthtracker schuf eine direkte, semantische und intuitiv verständliche Verbindung von virtuellem und realem Raum. Technologisch war er vom Trackball in der Computermaus abgeleitet: Das von ART+COM entwickelte System bestand aus drei Trackballs, auf denen eine große Kugel lag. In der Maus hat der Trackball lediglich eine technische Funktion – isoliert, vergrößert und in den Kontext von Terravision gesetzt, wurde er zum semantischen und skulpturalen Globus-Interface.

Als zusätzliches Interface wurde eine Space-Mouse eingesetzt, mit dem Nutzer räumlich navigieren konnten. In einer späteren Version von Terravision wurden die beiden Interfaces durch einen Touchscreen ergänzt, über den Nutzer mit der Information interagieren konnten. Die Kombination von zwei General Purpose Interfaces und einem selbstentwickelten semantischen Interface ermöglichte eine intuitive, mehrschichtige Navigation, bei der der Trackball das betrachtete Objekt steuert, die Space-Mouse den Betrachterstandpunkt, und der Touchscreen es ermöglicht, mit den eingeblendeten Informationen zu interagieren.

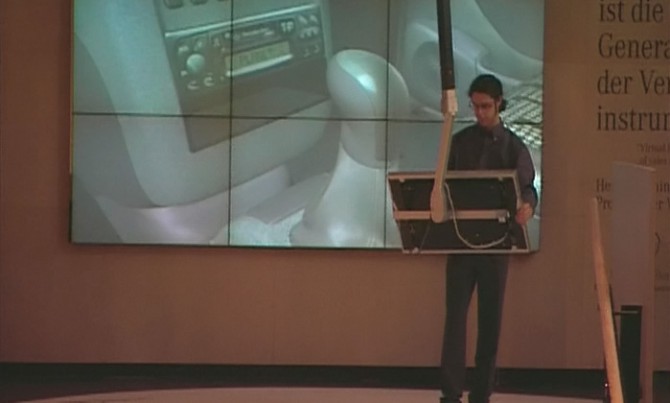

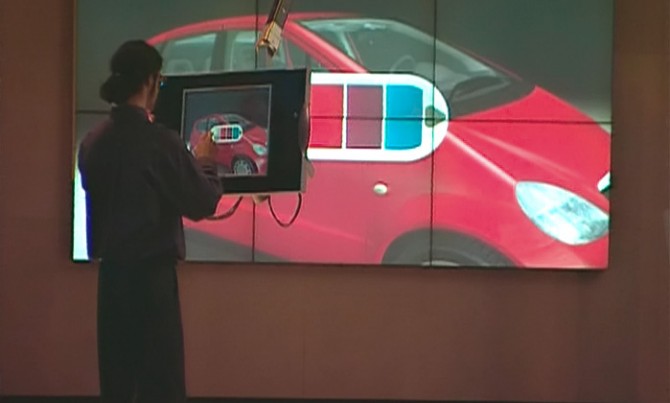

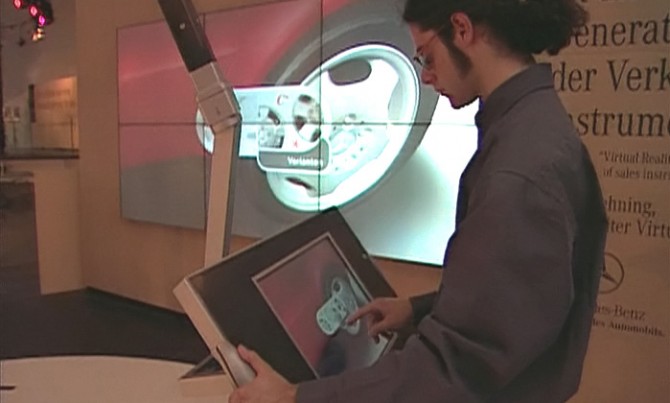

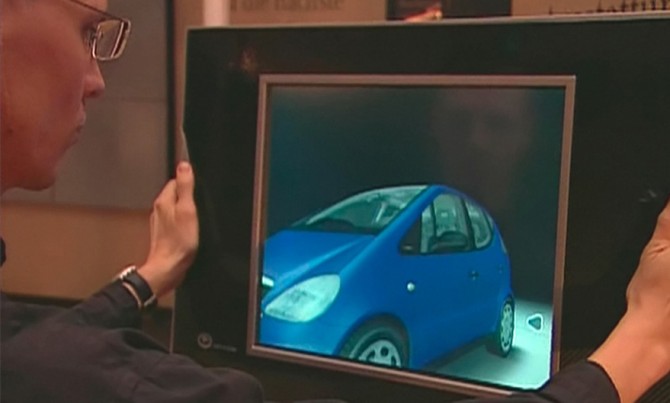

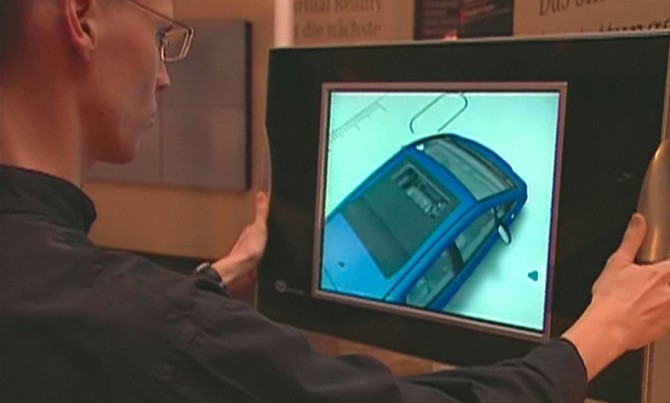

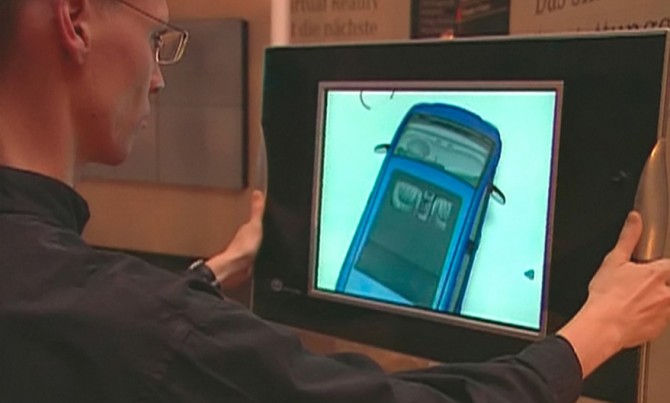

Für das Projekt Window into Virtuality (1997) wurden ebenfalls zwei Alternativen zu den damals üblichen VR-Interfaces entwickelt. Im Zentrum der Installation steht ein virtuelles, dreidimensionales Objekt: ein fotorealistisches Automobil im Maßstab 1:1. Um dieses herum konnte sich der Nutzer bewegen, es aus allen möglichen Blickwickeln betrachten und sogar im Innenraum Details aus nächster Nähe anschauen. Ermöglicht wurde dies durch einen mobilen Touchscreen, der an einen Teleskoparm montiert war und vom Nutzer durch den Raum und somit an das virtuelle Fahrzeug heran, um es herum und in es hinein bewegtwerden konnte. Auf dem Touchscreen konnten Informationen zum Fahrzeug abgerufen, und es konnte im Rahmen der angebotenen Varianten konfiguriert werden.

Das System war maßstäblich so aufgebaut, dass wenn sich der Nutzer im Realraum einen Meter bewegt, dies der Bewegung von einem Meter im virtuellen Raum gleichkam. Dadurch ergab sich eine absolute Navigation, bei der die Bewegung im Realraum der Bewegung im virtuellen Raum entsprach. Ein alternativer und parallel entwickelter Ansatz zu diesem raumgreifenden System mit absoluter Navigation stellte ein zweites System mit relativer Navigation dar. Dieses bestand lediglich aus einem auf einem hohen Standfuß angebrachten Monitor, mit dem man durch Drücken und Ziehen im virtuellen Raum navigierte. Der gleichmäßige Druck mit beiden Händen bewegte den Betrachter vorwärts, der Zug rückwärts. Der Druck mit nur einer Hand erzeugt einen Schwenk.

Die beiden Interfaces von Window to Virtuality gehen auf Experimente mit dem ersten erhältlichen LCD-Monitor zu Beginn der 1990er Jahre zurück. Diesen machten wir mobil, statteten ihn mit einem Polhemus Sensor aus und montierten eine Videokamera an dessen Rückseite. Das Monitorbild zeigte also wie heutige Tablets das Bild vor der Kamera; das Interface wurde quasi durchsichtig. Mithilfe der Daten des Positionssensors konnte dieses Bild in Echtzeit mit einem positionsgenauen, virtuellen Modell überlagert werden. Ganz bewusst wurde für Window to Virtuality auf einige Funktionen dieses Vorläufers verzichtet. Der Teleskoparm schränkte die Bewegung im Raum ein, was zu einer einfacheren Nutzung und zielgerichteten Vermittlung der Inhalte beitrug. Zudem wurde das virtuelle Fahrzeug bewusst nicht mit einem Kamerabild der Umgebung überlagert, sondern in einem virtuellen Raum dargestellt.

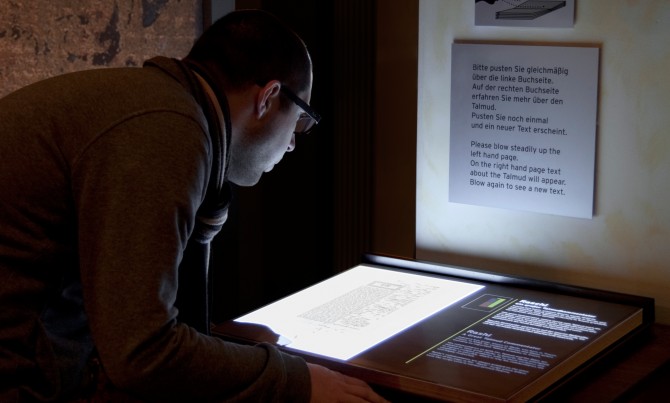

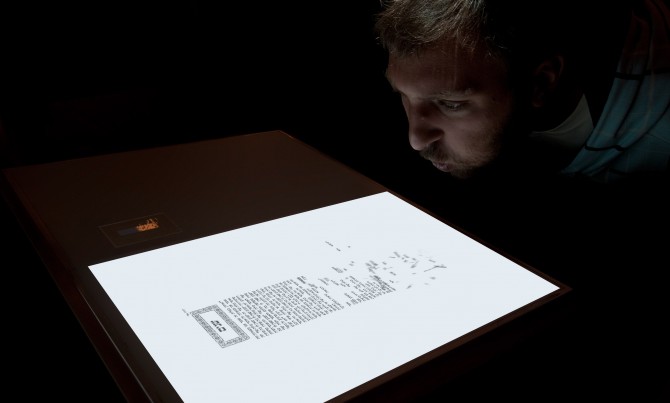

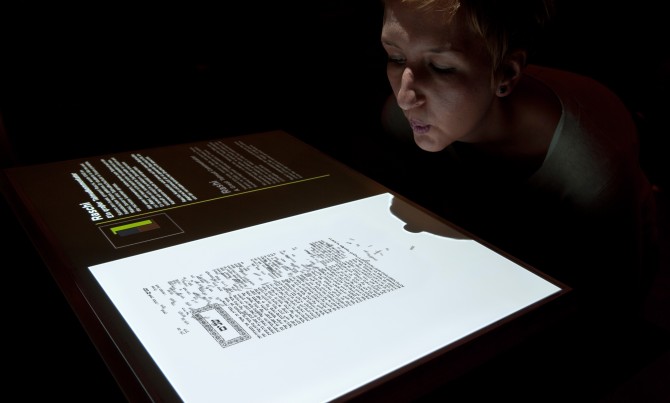

Der konzeptionelle Ausgangspunkt für das semantische Interfaces von Odem (2001) war die anfänglich mündliche Verkündung und Überlieferung des Talmuds und die Lehre vom Leben spendenden Odem Gottes. Als metaphorische Referenz wurde Windsensorik eingesetzt. In der Ausstellung tritt der Besucher einem aufgeschlagenen und scheinbar leeren Buch entgegen. Bläst der Besucher auf die linke Seite des Buches, bauen sich die Elemente des Talmuds nacheinander auf. Der Besucher lässt die Schrift durch seinen Atem erscheinen und erweckt das Buch quasi zum Leben.

Für die Ausstellung Das Neue Österreich (2005) entstand eine Installation in Form einer 250 Meter langen österreichischen Flagge, die sich durch das Schloss Belvedere zog und 17 Medieninstallationen beinhaltete. Entlang der Flagge konnten Besucher eine Reihe von Exponaten wie historische Tonaufnahmen oder Filme erkunden. Für die Gestaltung der semantischen Interfaces zweckentfremdeten wir allgemein bekannte Geräte, von denen sich auf die zu erkundenden Inhalte und die Interaktionsweise schließen ließ. Besucher konnten mit einem Mikroskop aus dem All, in Österreich hinein und bis hinunter auf sich selbst zoomen; oder die Stimme Kaiser Franz Josefs erklang leise durch Hörrohre, denen man sich nähern musste, um etwas zu verstehen.

In der Museumsausstellung Reykjavik871+/-2 (2006) galt es, die Gestalt und den Aufbau des ersten Langhauses Islands zu vermitteln. Auf Basis der Funde und ihrer wissenschaftlichen Auswertung visualisierten wir das Gebäude. An der Installation Archäologisches Fenster, die wir für die Ausstellung entwickelten, kann der Betrachter das virtuelle Langhaus von allen Seiten sehen und die unterschiedlichen Baustufen durch die Animation erfahren. Erste Überlegungen zum Interface führten zu einer Art mechanischen Kurbel, die Besucher der Ausstellung drehen können sollten, um das Langhaus rundherum zu betrachten. Doch erwies sich die Entwicklung einer Mechanik, die auch noch die zweite Interaktionsebene zuließ, als hochgradig komplex. Die Lösung lag schließlich in der Modifizierung eines General Purpose Interfaces, eines Touchscreens, auf den eine Schablone aus Plexiglas geklebt wurde. Bewegt der Ausstellungsbesucher seinen Finger entlang der axialen Zeitlinie, wird Schicht für Schicht des Langhauses eingeblendet. Diese Zeitlinie wird von konzentrischen Kreisen geschnitten. Bewegt man seinen Finger entlang einer dieser Kreislinien, dreht sich Langhaus samt seiner Umgebung, sodass der Eindruck entsteht, als würde man um das Langhaus in dem gewählten Bauzustand herum fliegen. Das minimalistische Interface leitet, limitiert und fokussiert die Nutzerinteraktion auf effiziente Weise. Die Haptik des Interfaces macht es dabei möglich, dass der Besucher mit dem Finger die Rillen entlangfährt und sich dabei ganz auf die Darstellung des Langhauses auf dem Wandmonitor konzentrieren kann.

Verschwinden der Interfaces

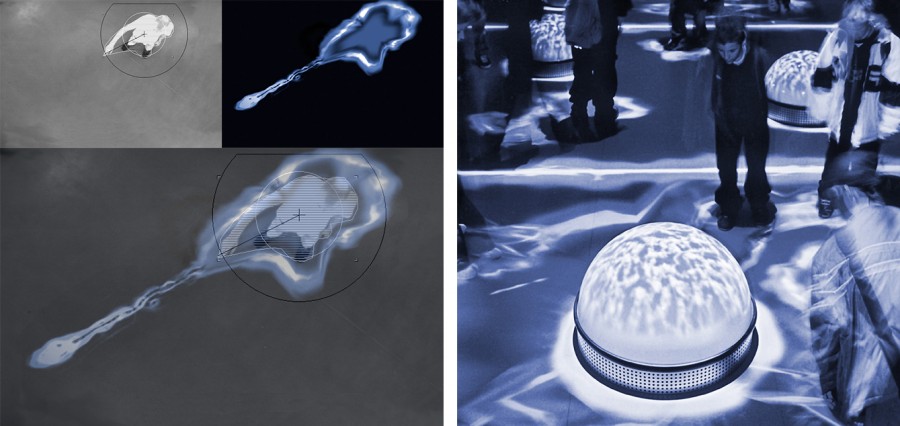

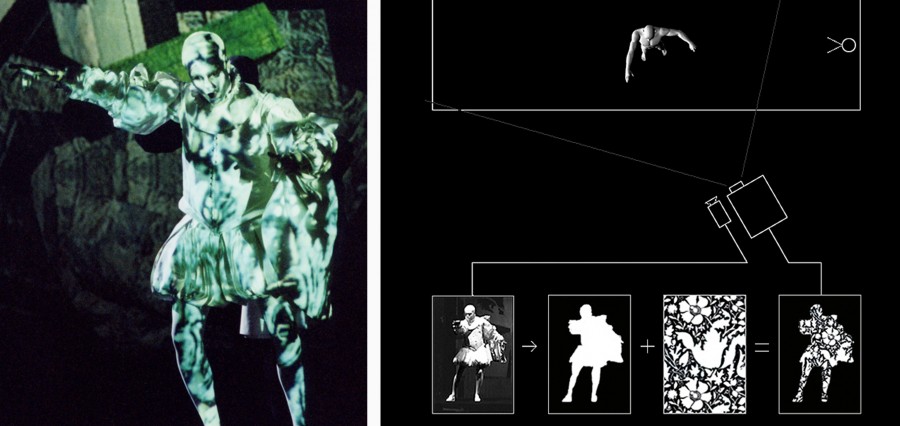

1992 war der Zerzeher noch ein avantgardistisches Einzelbeispiel für die Mensch-Maschine-Interaktion ohne physisches Interface. Ende der 1990er Jahre forschte ART+COM – neben der Entwicklung semantischer Interfaces – dann verstärkt zu Systemen, die eine unmittelbare Interaktion des Körpers mit virtuellen Objekten ermöglichen. Parallel arbeiteten wir an der Gestaltung der Installation Bodymover (2000) und des medialen Bühnenbildes für die Oper Der Jude von Malta (2002). Beide basierten auf dem gleichen Prinzip: der Kombination von Kamera-Tracking, Echtzeit-Analyse von Silhouetten und Echtzeit-Projektion.

Hauptfigur der Oper ist Machiavelli, der zu Beginn mächtig ist, im Laufe des Stückes aber seine Macht verliert. Dies war der konzeptionelle Ausgangspunkt für die Gestaltung des interaktiven Bühnenbildes, das zum handelnden Element wird, statt nur Ort der Handlung zu sein. Da die Kostümprojektion auf die sich über die Bühne bewegenden Sänger extrem präzise sein musste, floss viel Entwicklungsarbeit in die Software, die aus dem Kamerabild virtuelle Masken errechnete, durch die Texturen auf die Akteure projiziert wurden.

ART+COMs Suche nach alternativen Interfaces, die eine unmittelbare, körperliche Interaktion mit virtuellen Objekten und durch mehrere Nutzer gleichzeitig ermöglichen, führte ab 2002 zu einer Reihe von sensitiven Oberflächen, die von Böden zu Tischen und freien, nicht planen Formen reicht und technisch auf Kapazitätsensorik basiert. Mehr zum Thema sensitive Oberflächen hier.