Reale Räume und Objekte mit virtueller Information zu überlagern, ist nach wie vor eine wirkungsvolle Kommunikationsmethode. Dieses Verfahren hat sich als mediales Prinzip erwiesen, das mit unterschiedlichen Techniken und Interfaces umgesetzt werden kann.

Waren Home of the Brain (1992), VR Daimler (1992) und VR Stadtplanung (1989) noch komplette virtuelle und interaktive Environments, in denen man mittels Datenbrille und Datenhandschuh interagieren konnte, konzentrierte sich unsere Forschung Mitte der 90er Jahre auf die Kombination von realem und virtuellem Raum. Denn so immersiv VR-Environments auch waren, so isoliert war der Nutzer in ihnen. Durch VR-Interfaces vom Realraum abgeschottet, war kein Bezug zu diesem mehr möglich. Handschuh, Brille und deren Verkabelung schränkten zudem in der Bewegungsfreiheit stark ein. Augmentierung hingegen eröffnete neue Möglichkeiten der Kommunikation von orts- und objektbezogenen Informationen. Inhalte, die nicht im Realraum existieren, können in Form einer maßstäblichen, virtuellen Ebene zugänglich gemacht werden, die den Realraum überlagert.

AR mit mobilen Interfaces

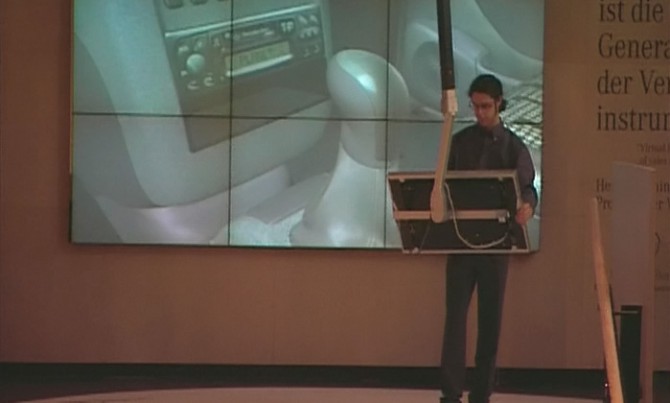

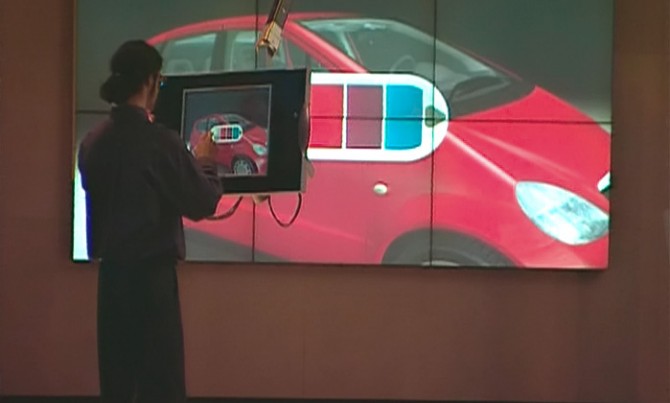

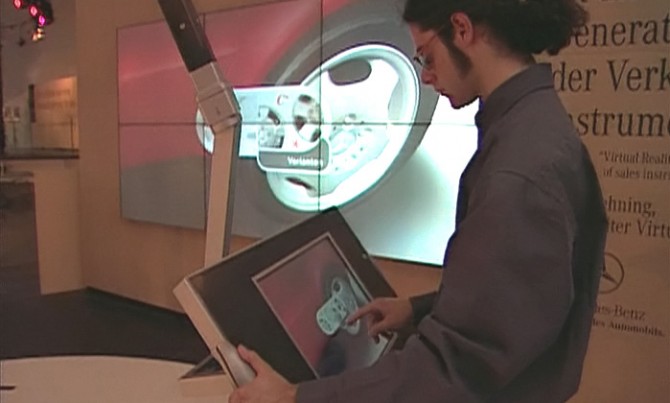

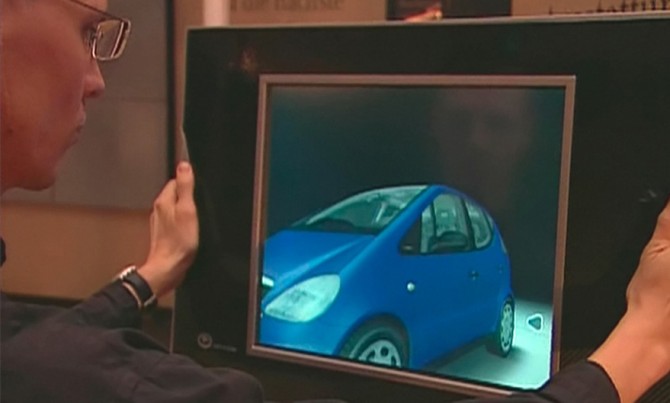

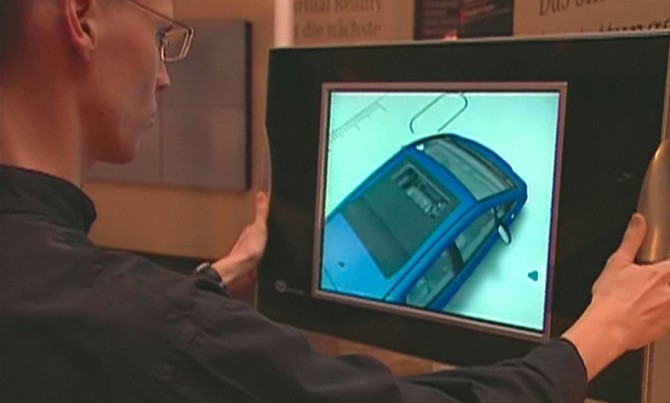

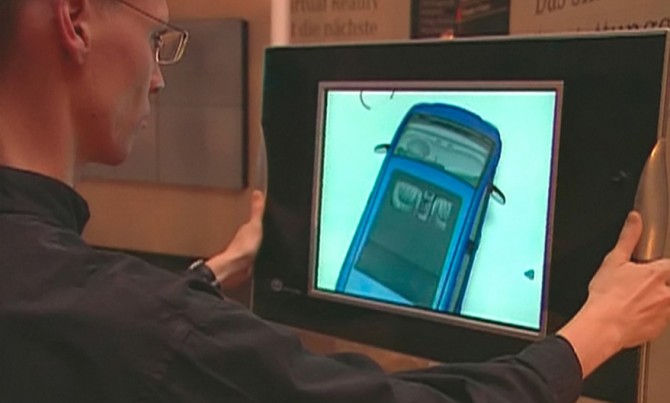

Mit dem Projekt Window into Virtuality (1997) nahm ART+COM das heute gängigste AR-Interface vorweg: den mobilen Screen. Für DaimlerChrysler entstand ein Showroom, in dem ein Automodell in all seinen Ausstattungsvarianten kommuniziert wurde. Um das Auto im 1:1 Maßstab darstellen zu können, gab es zwei Möglichkeiten: entweder das Kamerabild eines Realraums mit einem virtuellen Fahrzeug zu augmentieren oder das virtuelle Fahrzeug samt seiner nachmodellierten Showroom-Umgebung in den Realraum zu übersetzen.

Im Falle des Showrooms für DaimlerChrysler entschieden wir uns aus mehreren Gründen für die zweite Lösung. Sie war damals weniger aufwändig und absolut ausreichend, um das Fahrzeug in seiner originalen Größe im Raum erlebbar zu machen. Zudem ließ es sich so vermeiden, dass das Bild des virtuellen Fahrzeugs zum Beispiel durch das Livebild von Showroom-Besuchern überlagert wurde. Der mobile Bildschirm war an einen Teleskoparm montiert und konnte vom Nutzer durch den Raum und somit an das virtuelle Fahrzeug heran, um es herum und in es hinein bewegt werden. Das System war maßstäblich aufgebaut: Wenn sich der Nutzer mit dem Bildschirm einen Meter im Showroom bewegte, entsprach dies der Bewegung von einem Meter im virtuellen Raum. Zu dem intuitiv zu bedienenden Interface kam somit eine einfache, natürliche Orientierung im Raum hinzu.

Das erste, 1993 von uns entwickelte AR-Interface bestand aus dem damals ersten im Handel erhältlichen LCD-Monitor, der mit einer Stabkamera und einem Polhemus 3D Positionssensor kombiniert wurde.

Rund 20 Jahre später bedarf es keiner selbst-entwickelten Hardware mehr: Für die interaktiven Exponate der Reifenhäuser Gruppe nutzten wir handelsübliche Tablets, um die physischen Objekte zu augmentieren. Die detailreichen 3D-gedruckten Modelle der Produktionsanlagen können mit den Tablets umschritten und betrachtet werden, wobei sich eine interaktive Informationsebene über das Livebild legt. Gestaltet wurde diese mit einer existierenden Entwicklungsumgebung, die die Erkennung von dreidimensionalen Objekten ohne visuelle Marker ermöglicht. Um potentielle Störfaktoren zu eliminieren, wurden die Exponate samt einer „neutralen“, klaren Umgebung gestaltet. Bewusst wurden die Modelle auf niedrige Sockel gesetzt, um Aufsichten zu forcieren, in denen die Modelle das Kamerabild füllen.

AR mit festen Interfaces

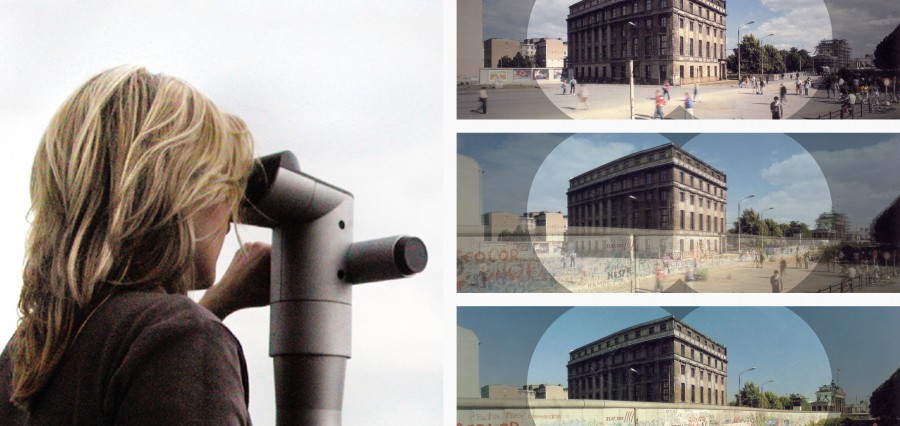

Berlin ist eine Stadt im schnellen Wandel, in der Geschichte ständig durch die Gegenwart überschrieben und unsichtbar wird. Vor allem nach der Wiedervereinigung veränderte sich das Stadtbild innerhalb von kürzester Zeit: Die Mauer und Grenzanlagen wurden abgerissen, und das ehemals fast unüberwindliche Bollwerk verschwand aus dem Blick. Aus dieser Situation heraus und etwa parallel zu Window into Virtuality entstand die Idee, mit einem fest installierten Interface die Berliner Mauer, die schon fast gänzlich abgerissen worden war, durch Augmentierung sichtbar zu machen und so auch Menschen, die die Stadt nicht geteilt erlebt haben, eine Vorstellung von der Mauer zu geben. Ursprünglich für einen Standort am Brandenburger Tor gedacht, funktionierte das Timescope (1996) ebenfalls ohne Livebild. Ein aktuelles Standbild des leeren Mauerstreifens, aufgenommen von der Timescope-Position, konnte mit historischen, bearbeiteten Aufnahmen überblendet werden.

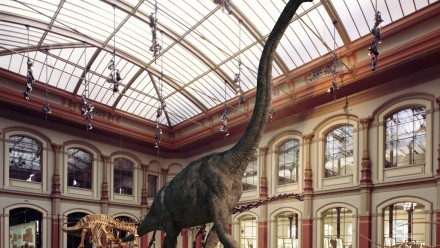

Das Timescope war die „schlanke“, erste Version der Virtuscopes, die im Laufe der Zeit in mehreren Varianten weiterentwickelt wurden. Durch die Jurascopes (2007) im Berliner Museum für Naturkunde beispielsweise sehen Besucher die ausgestellten Dinosaurierskelette und erleben, wie diese in ihrer ursprünglichen Umgebung lebendig werden, jagen und fressen.

In die Airportscopes (2011) am Zürcher Flughafen sind die Live-Kameras integriert. Mit ihnen lassen sich startende und landende Flugzeuge beobachten, über deren Livebild sich Informationen zum Flugzeugtyp, Abflugsort und Ziel legen. Dazu herangezogen werden Realtime-Daten aus der Flugsicherung, etwa vom Bodenradar, um die Flugzeuge auf der Basis ihrer Position zu identifizieren.

Im Gegensatz zu den AR-Anwendungen, die heute auf dem Markt angeboten werden, wurden und werden unsere Projekte in erster Linie aus gestalterischer Perspektive und für einen bestimmten Kontext entwickelt. Egal ob das Interface fest installiert oder mobil ist: die Augmentierung ist getrieben von den Inhalten, die vermittelt werde sollen und entsprechend fokussiert sich die Gestaltung stark auf die jeweiligen Objekte und Räume. Das gestalterische Prinzip bleibt unabhängig von der Technologie das gleiche, auch wenn in Zukunft immer mehr Mobilgeräte der Nutzer als Interfaces genutzt werden.

AR mit Pepper’s Ghost

Augmentierung ist ein Prinzip, das lange vor der Erfindung des Computers und Datenprojektoren mit verschiedenen Techniken erzielt wurde, etwa mit Pepper’s Ghost: eine analoge Projektionstechnik, die in Mitte des 19. Jahrhunderts zum ersten Mal auf der Bühne zum Einsatz kam. Gegenüber anderen Augmentierungstechniken bietet sie den Vorteil, technisch relativ einfach und damit robust zu sein. Der Pepper’s Ghost Effekt bietet somit eine elegante Lösung für die Überlagerung realer Objekte und Räume mit Stand- oder Bewegtbildern.

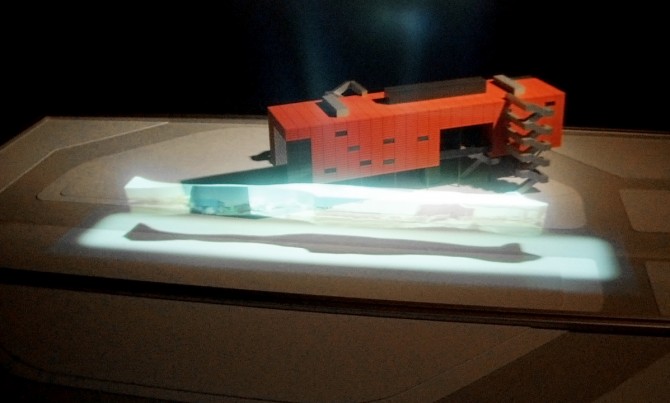

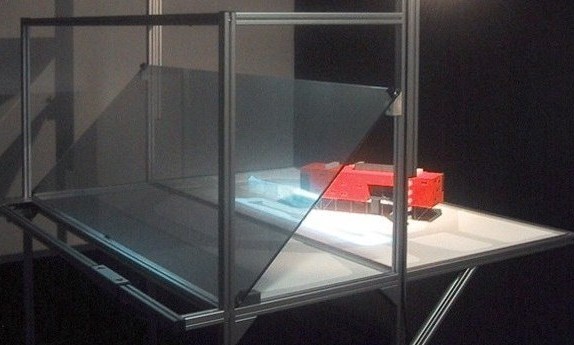

Wir haben im Rahmen unterschiedlicher Projekte auf diese alte Augmentierungstechnik zurückgegriffen und sie teilweise mit neuen Medien kombiniert: Für die Ausstellung des Projekts The Invisible Shape of Things Past (Museum of Contemporary Art Porto, 2001) entstand ein Architekturmodell, das mit einem dynamischen, virtuellen Modell augmentiert wurde. Um den Realismus zu erhöhen, wurde neben der Pepper’s Ghost Projektion auf das Spiegelglas noch der Schatten des Objektes direkt auf das Architekturmodell projiziert.

Beim Boulevard der Stars (2010) wurde der Effekt in den Sternguckern angewandt. Die Filmpersönlichkeiten erscheinen als Standbilder auf dem Boulevard, wo sie betrachtet und zusammen mit den Besuchern durch die Sterngucker hindurch fotografiert werden können.

Auch im BrandSpace (2011) der Deutschen Bank in Frankfurt basiert ein Exponat auf dem Pepper’s Ghost Effekt: Über das plastische Modell der Deutsche Bank Türme legen sich animierte Grafiken, die die ökologischen Effekte der Renovierung illustrieren. Vor dem Modell liegt ein Buch, das thematisch gegliedert über die Maßnahmen informiert. Blättert der Besucher um, erscheint auf den Türmen und um sie herum die jeweilige zum Thema passende animierte Grafik.

Reale Räume und Objekte mit virtueller Information zu überlagern, ist nach wie vor eine wirkungsvolle Kommunikationsmethode, die in Zukunft weiter ausreifen wird. Während die visuellen Effekte im Film immer realistischer aussehen, jedoch den Kinoraum nicht verlassen, hat die AR im physischen Raum einen realräumlichen Bezug. Das augmentierte Objekt verliert nicht seine Aura, während die „Vor Ort“-Visualisierung seine Bedeutung zusätzlich vermittelt.